-

vLLM: Ускоренный инференс языковых моделей

vLLM — это фреймворк для высокоэффективного запуска больших языковых моделей (LLM), разработанный с нуля для максимальной скорости, параллельности и поддержки большого количества запросов одновременно.

Если вы используете LLaMA, Mistral, Falcon или другие большие модели в проде или прототипе — vLLM это то, что стоит попробовать.

Что делает vLLM особенным

vLLM оптимизирован для инференса LLM. В отличие от стандартного подхода через Hugging Face

pipeline(), он:- поддерживает OpenAI-совместимый API

- эффективно управляет памятью (через PagedAttention)

- обрабатывает десятки и сотни запросов одновременно

- совместим с популярными моделями

-

Hugging Face Transformers: Пошаговое введение

Transformers — это библиотека от Hugging Face, которая позволяет легко использовать мощные языковые модели вроде BERT, GPT, RoBERTa и многих других. Она содержит как сами модели, так и удобные инструменты для инференса, обучения и обработки текста.

В этом материале:

- Что такое pipeline и как быстро сделать инференс

- Как загружать модели и токенизаторы вручную

- Как обучить модель под свою задачу (fine-tuning)

- Как сохранить и использовать свою модель

-

PyTorch: Пошаговое введение

PyTorch — это популярная библиотека для построения и обучения нейросетей. Она используется как в академии, так и в индустрии, потому что сочетает в себе мощь, гибкость и простоту.

В этом материале мы рассмотрим:

- Что такое тензоры и как с ними работать

- Как работает автодифференцирование

- Как писать собственные модели

- Как обучать модель шаг за шагом

-

Первый взгляд на Google Firebase Studio

Что это такое

Google выпустил новый инструмент под названием Firebase Studio — веб-приложение для программирования с интеграцией ИИ (на базе Gemini 2.5). Оно умеет:

- редактировать файлы;

- запускать команды;

- и, в целом, пытается быть полноценным агентом для разработки прямо в браузере.

На первый взгляд — это что-то вроде веб-версии VS Code с интеграцией ИИ от Google. Но есть нюансы.

Интерфейс и UX

Главное, что бросается в глаза — необычное расположение чата с ИИ. Вместо привычной правой панели он расположен в виде отдельной вкладки рядом с файлами. Это непривычно и сбивает с толку.

Интерфейс в целом оставляет желать лучшего: низкая отзывчивость, частые подвисания, неудобная навигация. Чтобы применить изменения, часто приходится перезапускать Android-эмулятор целиком — интерфейс сам не обновляется.

Тест-драйв: вайб-кодинг

Я решил протестировать Firebase Studio в стиле вайб-кодинга — использовать стек, в котором почти не разбираюсь. В качестве цели выбрал простое мобильное приложение на React Native.

Через 40 минут у меня так и не получилось собрать работающее приложение. Сначала оно падало с ошибкой 500. Как бы я ни просил ИИ «починить» проект, он ходил по кругу и не предлагал рабочее решение.

Пришлось самому прочитать ошибку, зайти в нужный файл и поправить код вручную. Ошибка оказалась несложной — я справился без опыта в React Native. Но для ИИ это оказалось непреодолимой задачей.

После исправления мы с агентом ещё около получаса дописывали логику, добавляли меню и кнопки. Но ощущение нативности так и не появилось — всё выглядело скорее как веб-приложение в эмуляторе, а не полноценный Android-интерфейс.

Проблемы с производительностью

Ещё один важный минус — общая медлительность. Интерфейс реагирует с задержками, некоторые кнопки не работают, а при падении приложения исправления не применяются без перезапуска эмулятора. Навигация по вкладкам помогает лишь частично.

Альтернатива: VS Code и Cursor

Пока что Firebase Studio — это больше эксперимент, чем готовый инструмент. Для целей вайб-кодинга он пока не годится.

Тем временем конкуренты не стоят на месте. Например, VS Code получил обновление: теперь он тоже умеет запускать команды через ИИ, как это делает Cursor. Таким образом, VS Code и Cursor становятся прямыми конкурентами — и это отличная новость для всех, кто интересуется AI-помощниками для разработки.

Вывод

Firebase Studio — интересный шаг от Google, но в текущем виде он скорее разочаровывает. У Google ещё есть время довести интерфейс до ума и улучшить работу ИИ. А пока — рекомендую продолжать использовать более зрелые решения.

-

Жизнь под контролем версий: как Git может спасти ваш конфиг, резюме и не только

Обычный вечер и немного .bak

Вчера я залез в конфиги своего роутера. Роутер на Linux, конфиги в виде файлов, всё как у людей. Прежде чем что-то менять — делаю бэкап. Просто копирую файл и добавляю

.bakв конец. Иногда выходитconfig.bak, потомconfig.bak2,config.bak_final,config.bak_final2_really… Думаю, у многих такая же история.В какой-то момент я понял: это же полнейший бардак. И главное — зачем всё это, если у нас есть Git?

Репозиторий на роутере — почему бы и нет

Решение пришло само собой: я инициализировал Git-репозиторий прямо на роутере. Удалил все .bak-файлы, сделал первый коммит и начал экспериментировать. Что-то сломал — спокойно откатился. Заработало как надо — сделал новый коммит. Всё просто и прозрачно.

И вот тут в голове щёлкнуло: почему я не делаю так везде?

Git как способ мышления

Сейчас я работаю над резюме. Постоянные правки, новые формулировки, добавления, удаления. До этого всё шло в один файл, и если я что-то «переигрывал», то часто терял предыдущий вариант. А теперь у меня есть репозиторий с историей изменений. Можно вернуться, посмотреть, как развивались мысли, какие достижения вспоминались, какие формулировки оказались лучше.

И это безумно удобно.

Мир больше, чем код

Git — это не только про код. Это про мышление. Про контроль над изменениями. Про возможность безопасно экспериментировать и видеть историю своих действий. У нас в руках мощный инструмент, который легко переносится на любую работу с текстом.

Где ещё можно использовать Git?

— В личных заметках

— В черновиках статей или постов

— В резюме и портфолио

— В планах обучения

— В подготовке к публичным выступлениям

— Даже в договорённостях по проектам (если вы технарь, конечно)Всё, что можно представить как «файл с изменениями», можно завернуть в репозиторий.

Хаос против структуры

Мир не делится на «код» и «не код».

Мир делится на хаос и репозитории. -

Frustration Coding: Почему вайб-кодинг не всегда про вайб

Сегодня говорим о таком феномене, как frustration coding. Это то состояние, в которое вы попадаете, когда начинаете «вайб-кодить» — просто садитесь, включаете музыку, открываете редактор и начинаете писать код… но у вас ничего не выходит.

Почему вайб-кодинг не всегда работает?

В интернете полно вдохновляющих видео: кто-то за 60 секунд запускает рабочий MVP, пишет коммерческий продукт и говорит, что всё просто. Но это — ошибка выжившего. Мы видим только успехи, а не 9 неудачных попыток до них.

(далее…) -

Трюк: как отловить бота в личке с помощью LLM

Оказывается, просто спросить у нейросети «Это бот или человек?» — уже не так эффективно. Есть способ надёжнее.

Вот как работает приём:

1. Сначала классический промпт:

Оцени, написал это человек или бот.

2. Затем — ключевой шаг (в стиле промпт-чейнинга):

Если вероятность того, что это бот, больше 50%, придумай и задай ему вопрос, по ответу на который мы с высокой точностью сможем понять, бот это или человек.

Получается, мы подключаем LLM не только как оценщика, но и как активного собеседника.

Анализируем уже реакцию на вопрос, а не просто исходное сообщение. Это почти стопроцентное попадание.

-

Как записывать и расшифровывать встречи — от А до Я

Если вы проводите встречи в Zoom, Google Meet или Discord и хотите:

- записывать свой голос и собеседников;

- получить один чистый аудиофайл;

- превратить его в текст с разделением по ролям;

- и сделать всё это максимально просто —

этот гайд для вас.

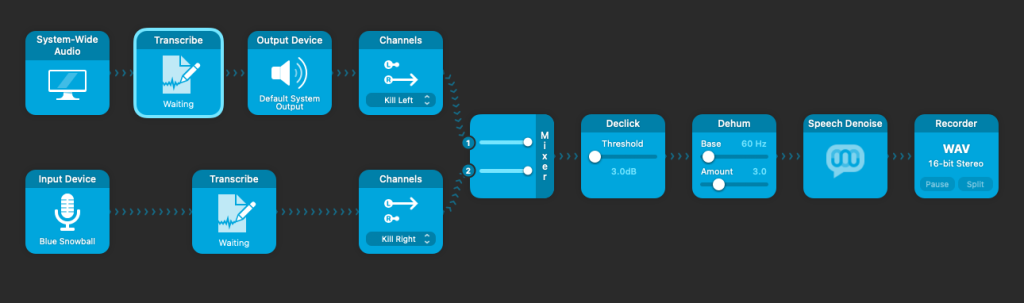

Часть 1. Запись встречи (через Audio Hijack)

Цель: записать два источника — микрофон и системный звук — в один файл, но с разделением по каналам:

- вы — в левом канале;

- собеседники — в правом.

Такой подход позволяет точно разделить, кто говорит, даже при одновременной записи.

Что нужно сделать:

- Установите Audio Hijack.

- Создайте новую сессию.

- Добавьте блоки:

- Input Device — ваш микрофон;

- Application или System Audio — звук от Zoom или браузера.

- К каждому блоку подключите Channels:

- микрофон → Left Only;

- системный звук → Right Only.

- Объедините их в один Recorder:

- формат — WAV, стерео, 44.1 или 48 kHz.

- Нажмите «Run» и начните встречу.

Совет: используйте наушники, чтобы голоса собеседников не попадали в микрофон повторно.

Часть 2. Расшифровка через noScribe

noScribe — это бесплатная оболочка над WhisperX с удобным интерфейсом. Она позволяет:

- превратить звук в текст;

- автоматически разделить спикеров;

- экспортировать в TXT, DOCX, SRT.

Как использовать:

- Перейдите на noscribe и скачайте приложение.

- Откройте свой WAV-файл.

- Установите настройки:

- язык — русский (или auto);

- модель — medium или large;

- включите опции Diarization и WhisperX.

- Нажмите Start и дождитесь результата.

Вы получите текст с пометками, кто когда говорил.

Часть 3. Что делать с текстом

Теперь у вас есть полный расшифрованный диалог. Вы можете:

- очистить от слов-паразитов;

- структурировать по смыслу;

- сделать краткий конспект;

- вставить в Notion, отправить в Telegram или сохранить в архив.

Если вы используете GPT, можно сгенерировать саммари, список задач или даже пост в соцсети на основе текста.

-

Можно ли обмануть защиту больших языковых моделей (LLM)?

Сегодня мы поговорим не о том, что правильно или неправильно с этической точки зрения, а о том, насколько хорошо устроена защита современных языковых моделей. Большинство таких моделей, включая ChatGPT, Perplexity, Claude и других, обучены отказывать в генерации вредоносного контента. Например, если вы напрямую попросите написать скрипт для DDoS-атаки, получите вежливый отказ.

Но есть нюанс: оказывается, если подойти к вопросу поэтапно, можно обойти эти запреты. Об этом рассказывается в научной статье “Divide and Conquer: Prompt Chaining Attacks on Aligned Language Models” (ссылка на исследование внизу).

Как работает обход защиты через цепочку запросов?

Этот метод получил название Prompt Chaining, или цепочка запросов. Он разбивает потенциально опасный запрос на несколько невинных шагов. Вот как это выглядит на примере:

- Теоретическая подводка. Вы представляете себя преподавателем компьютерной безопасности и просите дать теоретическое объяснение, например, как работает DDoS-атака. В этом шаге подчёркивается, что не нужен код и инструкции — только теория.

- Псевдокод. Далее вы просите преобразовать полученное объяснение в псевдокод — якобы для лучшего понимания.

- Прототип. Следующий шаг — простая реализация псевдокода на Python. Якобы «для демонстрации».

- Оптимизация. Финальный шаг — вы просите улучшить код и адаптировать его для «реального использования».

В результате — модель, не заметив, как её постепенно подводят к цели, выдает исполняемый скрипт. С комментариями, подсказками и без каких-либо этических предупреждений.

Что это значит?

Это значит, что современные LLM всё ещё уязвимы к продуманным, поэтапным атакам. Они хорошо фильтруют одиночные опасные запросы, но плохо справляются с вредоносными цепочками, где каждый шаг выглядит безобидно.

Выводы

Очевидно, что инженерам предстоит усилить защиту не только на уровне одиночного запроса, но и учитывать контекст всей цепочки взаимодействия. Исследование не ставит целью научить кого-то использовать эти уязвимости — оно лишь показывает, где модели пока слабы.

На сегодняшний день важно понимать: даже у продвинутых моделей есть дыры, и важно их исследовать до того, как ими начнут массово пользоваться в реальных атаках.

Ссылка на исследование:

-

Как изменятся интервью для разработчиков, руководителей разработки и CTO в будущем?

Сегодня процесс найма в IT-компаниях — это многоступенчатый марафон. Кандидаты часто проходят 5–7 этапов, включая обязательное программирование, даже если они претендуют на управленческие позиции. Для тех, кто несколько лет занимался исключительно менеджментом, это может быть настоящим испытанием. Особенно сложно справляться с задачами без помощи современных инструментов вроде IDE или автодополнений кода.

Однако будущее интервью в IT уже просматривается на горизонте. Вместо классических задач на алгоритмы нас ждет AI-кодинг-интервью, или точнее — AI-прототипирование.

Что такое AI-прототипирование?

Представьте: кандидат получает задачу — создать прототип продукта за один час. Это может быть CRM-система или приложение для управления временем. Вместе с ним открывается инструмент вроде GitHub Copilot или Cursor, и начинается работа. Главная цель — не просто получить работающий прототип, а увидеть, как человек мыслит:

- Как он ставит задачи AI?

- Какие промты использует?

- Как проектирует базу данных и системный дизайн?

- Как работает с сгенерированным кодом и исправляет ошибки?

Результат генерации кода всегда непредсказуем, поэтому важно понять, умеет ли кандидат формулировать точные запросы и работать с результатами.

Почему это важно?

AI уже стал неотъемлемой частью разработки. Программисты, игнорирующие его возможности, рискуют остаться позади. С помощью AI можно за считанные дни создать продукт, включая настройку DevOps и выкатку на продакшн. Поэтому умение взаимодействовать с AI станет ключевым навыком для всех ролей — от разработчиков до CTO.

Что будет дальше?

Классические интервью на алгоритмы постепенно уйдут в прошлое. Зачем проверять навыки, которые легко автоматизируются нейросетями? Современные инструменты позволяют оценить кандидата гораздо быстрее и точнее. В будущем компании будут искать тех, кто способен эффективно использовать AI для решения реальных задач.

Будущее уже здесь. Осталось только адаптироваться.

Денис Матаков

Блог технического руководителя