-

Секреты продуктивной работы с Claude Code

Работа с Claude Code требует некоторой дисциплины. Если правильно выстроить процесс, можно получить качественный результат и при этом экономить лимиты. Ниже я описал основные шаги, которые использую сам.

1. Подготовка репозитория: README

Первое, что необходимо сделать в новом проекте, — попросить Claude сгенерировать

README.md. Но не в «человеческом» понимании, где много описаний, картинок и диаграмм, а в утилитарном виде:- структура папок,

- расположение моделей, миграций, ключевых функций,

- краткое назначение каждого блока.

Формулировать запрос стоит максимально чётко: «Напиши краткий README, который ты будешь использовать для дальнейшей работы над новыми фичами». Такой файл избавит от лишних затрат токенов при повторных обращениях.

(далее…) -

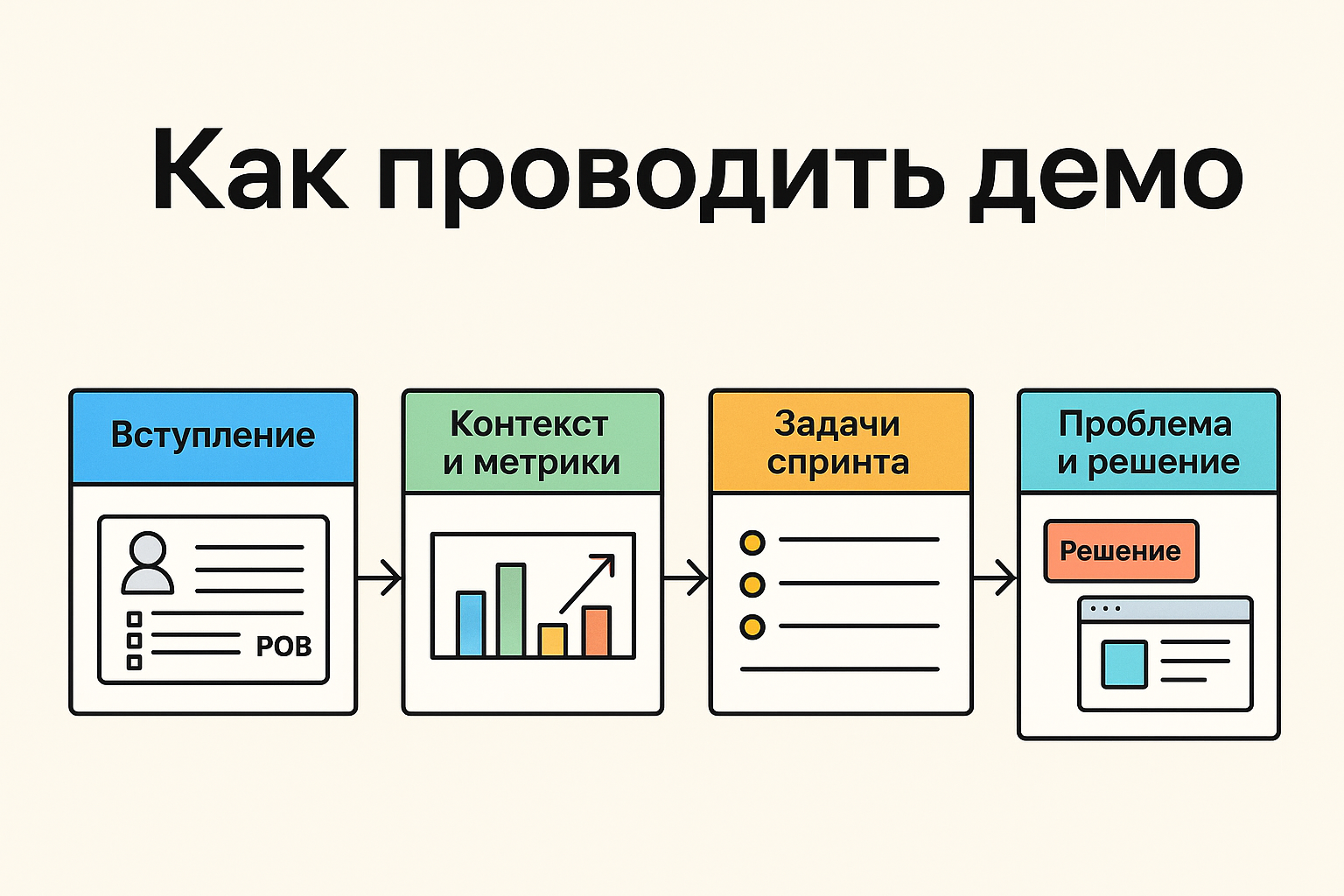

Как проводить демо: структура, слайды и акценты

Демо — это не отчёт для галочки, а инструмент, который показывает ценность сделанной работы для бизнеса и пользователей. Чтобы команда и стейкхолдеры одинаково понимали, зачем и что мы сделали, презентация должна быть выстроена по логике «от ценности — к решению».

1. Вступление: команда и цель спринта

Слайды:

- Название команды и даты спринта.

- Роли (PO, BA, BE, FE, QA, MOB, Design) и укомплектованность.

- Цель спринта (1–2 предложения, не «сделать задачи», а «проверить гипотезу/закрыть потребность/улучшить метрику»).

Совет: цель должна быть связана с ценностью для бизнеса или пользователя.

2. Контекст и метрики

Слайды:

- Ключевые продуктовые метрики: DAU/MAU, CSI, рост/падение.

- Изменения по сравнению с прошлым периодом (стрелки или график).

Совет: акцентируй внимание не на цифрах ради цифр, а на том, как текущая работа помогает улучшать метрики.

(далее…) -

Первый опыт с Claude Code: зачем мне консольный ИИ-ассистент разработчика

Недавно подключил Claude Code и провёл с ним несколько часов в реальном проекте. Ниже — мой практический разбор: чем он отличается от Copilot и Cursor, где оказался сильнее, какие есть ограничения по тарифам и как это можно внедрять в команду.

Что это и чем отличается от привычных ассистентов в IDE

Claude Code — не «ещё одна вкладка» в редакторе, а консольное приложение. Это одновременно минус и плюс. Минус — меньше «визуального» взаимодействия: не выделишь мышкой фрагмент, не перетащишь картинку. Плюс — независимость от конкретной IDE и даже от графической ОС: можно подключаться к любому серверу и работать через терминал с файлами, коммитами и проверками в реальном времени. Для конфигов на сервере это особенно удобно: формулируешь задачу по-человечески — получаешь результат, не ковыряясь в Vim или nano.

(далее…) -

CTO без хаоса: создаем адаптивный плейбук за 7 шагов

Когда технический директор приходит в компанию без базовых процессов, продукт превращается в череду хаотичных «подвигов». Чтобы вернуть предсказуемость, сначала наденьте шляпу директора по трансформации и выстройте фундамент.

Что важно включить в адаптивный плейбук?

- Спринты и ритуалы. Определяем продолжительность, частоту встреч и четкое расписание: планирование, ежедневные стендапы, ревью, ретро.

- Метрики ценности. Фокус не на закрытых задачах, а на том, сколько пользы получает клиент.

- Автономность команд. Полномочия + ответственность = скорость без микроменеджмента.

- Прозрачность. Общий календарь релизов, открытые доски задач, видимые цели.

- Устойчивая скорость. Откажитесь от «геройских» овертаймов — выигрыш в долгую даёт именно стабильный темп.

- Постоянное улучшение. Каждая ретроспектива — не отчёт о неудачах, а план апгрейда процессов.

- Живая документация. 24-страничный плейбук должен обновляться по эволюции команды, а не пылиться в Wiki.

-

Как работает MCP: внешний разум для вашей LLM

Когда мы говорим о современных языковых моделях вроде GPT или Claude, легко забыть, что всё, что они знают — это текст, который они когда-то прочитали. А значит, всё, чего они не знают, остаётся за пределами их внимания. И вот тут появляется MCP — Model Context Protocol. Это способ «расширить сознание» модели, подключив её к живым данным, инструментам и действиям.

Эта статья отвечает на важные вопросы, которые возникают, когда ты впервые сталкиваешься с MCP:

- Что именно он делает?

- Чем он отличается от API?

- Как модель узнаёт, какие инструменты есть?

- Где лежат адреса, авторизация и прочее?

- Можно ли через MCP совершать не только запросы, но и действия?

-

Как я писал MVP с AI-ассистентами: опыт, грабли и тактика

Недавно я делал мобильное приложение на Flutter, с FastAPI на бэкенде и Streamlit для административной панели. Всё это — в рамках подхода “AI-first”, когда почти весь код пишется с помощью копайлот-ассистентов: Gemini, ChatGPT, Claude.

И вот что я понял из такого долгосрочного программирования…

Умные, но забывчивые

Современные копайлот-ассистенты — это не команда, а стажёры. Они пишут быстро, но:

- забывают, что делали в предыдущем файле;

- не держат в голове структуру проекта;

- путаются, если вы перескакиваете между фронтом, мобилкой и бэком.

Мораль: не стоит надеяться, что AI вспомнит, как вы называли переменную три дня назад в другом микросервисе. Но выход есть.

(далее…) -

Как настроить мультиязычную встречу в Google Meet с автопереводом

Команды становятся всё более интернациональными — участники говорят на английском, русском, французском, испанском и даже китайском. Но как провести созвон, если не все владеют одним общим языком? Удивительно, но Google Meet уже умеет помогать в таких ситуациях: автоматически распознавать речь и переводить её в субтитры.

Звучит как магия, и — спойлер — работает это действительно хорошо. Особенно если на встрече используется два языка. Когда больше — потребуется чуть больше внимания к настройке, но и это вполне реально.

Что нужно для работы

Google Meet умеет автоперевод только в платных версиях (Google Workspace Business/Enterprise). Также потребуется:

- компьютер (на мобильных устройствах есть ограничения),

- браузер Google Chrome (он самый стабильный для этой функции),

- и немного терпения на начальной настройке.

-

Эпохи и переобучение: как понять, когда модель уже научилась

При обучении моделей машинного обучения часто возникает вопрос: сколько эпох нужно? Когда модель уже «поняла» данные, а когда она начинает запоминать их слишком точно (то есть переобучаться)?

В этой статье:

- Что такое эпоха

- Как понять, что модель переобучается

- Сколько эпох нужно

- Как выбрать и настроить обучение правильно

Что такое эпоха

Эпоха — это один полный проход по всему обучающему набору данных.

Допустим, у вас есть 10 000 примеров, и вы обучаете модель с

batch_size=100. Это значит, за одну эпоху модель увидит все примеры по 100 штук за раз — всего 100 шагов.Когда эпох несколько, модель повторно видит одни и те же данные, чтобы «отточить» предсказания.

(далее…) -

Обзор методов квантования языковых моделей: GPTQ, GGUF, QLoRA

Большие языковые модели (LLM) часто требуют десятки гигабайт видеопамяти и мощные серверы для запуска и обучения. Квантование — это способ уменьшить объём модели и ускорить её работу, с минимальной потерей качества.

В этой статье:

- Что такое квантование

- Какие есть методы: GPTQ, GGUF, QLoRA

- Чем они отличаются

- Когда и как их применять

Что такое квантование

Квантование — это перевод весов модели из 32-битного формата (

float32) в более компактные форматы:float16,int8,int4и т. д.Цель:

- уменьшить размер модели (в 2–8 раз)

- сократить использование VRAM

- ускорить инференс

Пример: модель в

(далее…)fp32весит 13 ГБ, а вint4— 3–4 ГБ. -

Базовая инфраструктура для запуска LLM: Triton, ONNX, TorchScript и другие

Когда модель готова, важно не только её обучить, но и запустить эффективно, особенно если она используется в проде. Большие языковые модели (LLM) требуют особого подхода к инференсу — и тут приходят на помощь оптимизированные форматы и инференс-серверы.

Что нужно для продакшен-инференса

- Высокая скорость обработки запросов

- Эффективное использование GPU

- Поддержка большого числа одновременных пользователей

- Гибкость и переносимость модели

Обычный

(далее…)pipeline()из Hugging Face удобен, но не масштабируется. Для продакшена нужны другие инструменты.

Денис Матаков

Блог технического руководителя